九州官方网站 版权所有 2003-2023

-

您的位置:

- 网站首页

- > 九州(中国)科技有限公司官网

- > 鲸品堂

您的位置:

过采样(over-sampling)

欠采样(under-sampling)

综合采样法

从学习模型出发

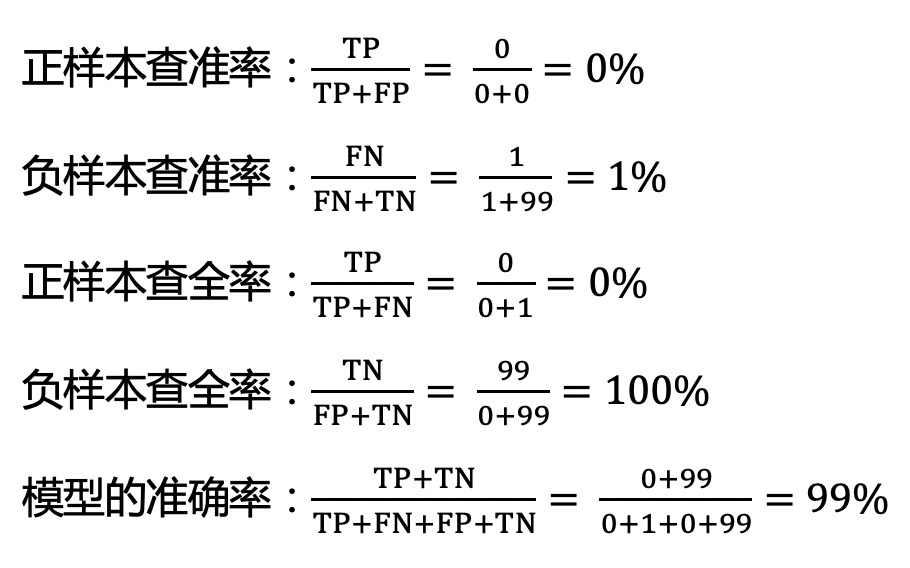

从贝叶斯风险理论出发

。此方法的优点在于它可以不依赖所用具体的分类器,但是缺点也很明显它要求分类器输出值为概率。

。此方法的优点在于它可以不依赖所用具体的分类器,但是缺点也很明显它要求分类器输出值为概率。从预处理的角度出发

静态数据,即用户的基本信息,如性别、年龄、入网时长、归属地市等。

动态数据,指用户的行为数据,如使用习惯、消费行为等。

标识数据,如“是否开通家庭网”、“是否当月订购‘和彩云’”等。

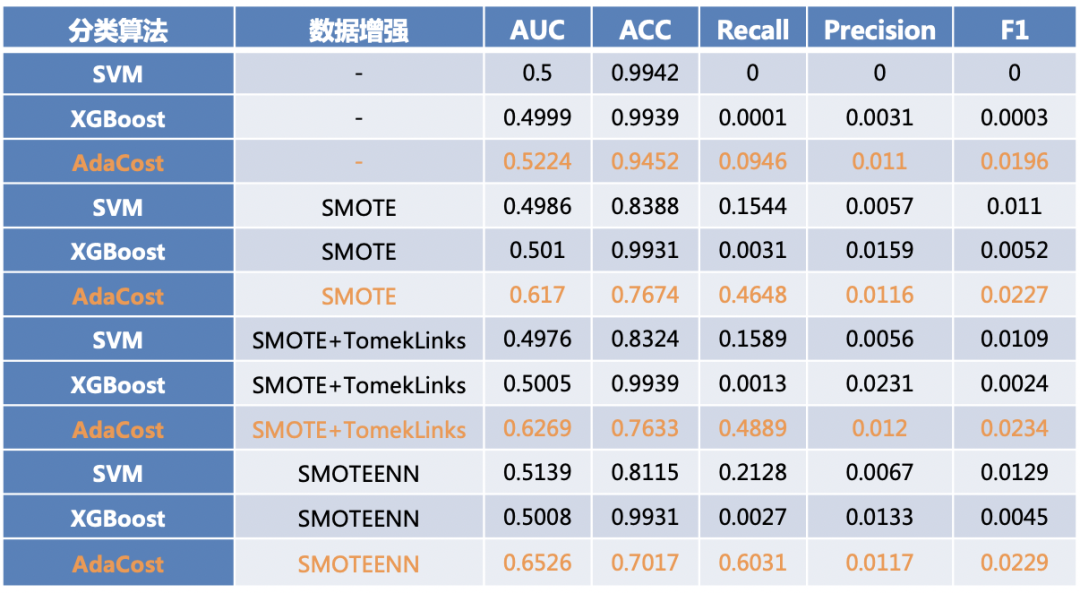

数据采样方面,对比未做任何处理的训练集,经过数据增强的训练集建模效果提升很大。与只进行过采样(SMOTE)的训练集进行对比,进一步剔除部分干扰样本(SMOTE+TomekLinks)后的训练集模型泛化能力亦有所提升。

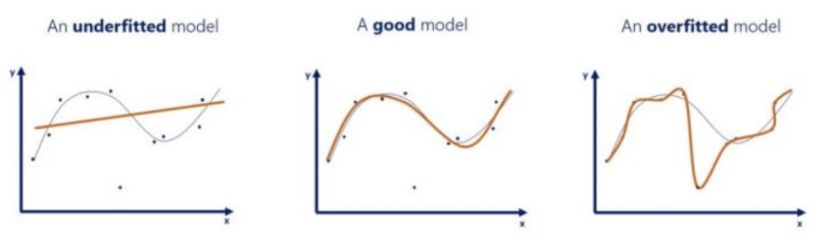

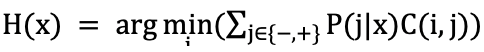

模型选择方面,基础机器学习算法SVM学习能力不足,分类效果不佳。XGBoost算法虽然能得出较高的精确率,但其在选择正样本时较为谨慎,导致召回率过低,同样亦不适用于小样本训练。AdaCost是基于代价敏感学习的boosting算法,在小样本不平衡数据集中有较好的效果。

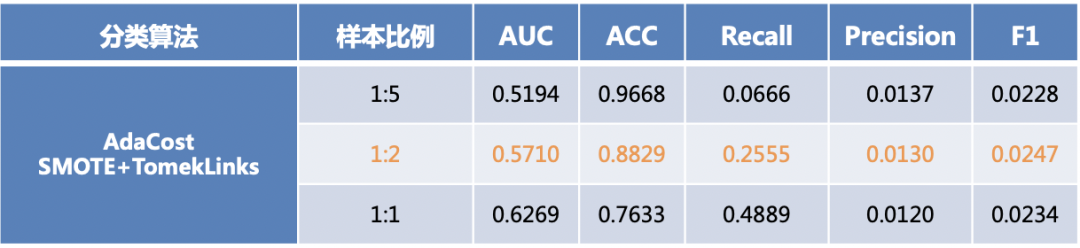

样本比例方面,当生成的少数类较少,模型从少数类样本中学不到足够多的信息;若生成的样本过多,会导致生成样本把原始样本信息覆盖。

模型超参方面,代价系数增大,代表着误杀成本更高,模型倾向于把更多的样本分类为正样本(召回率提高),但是精确率会随之有所下降,模型使用者可以根据需求控制模型的效果。