九州官方网站 版权所有 2003-2023

-

您的位置:

- 网站首页

- > 九州(中国)科技有限公司官网

- > 鲸品堂

您的位置:

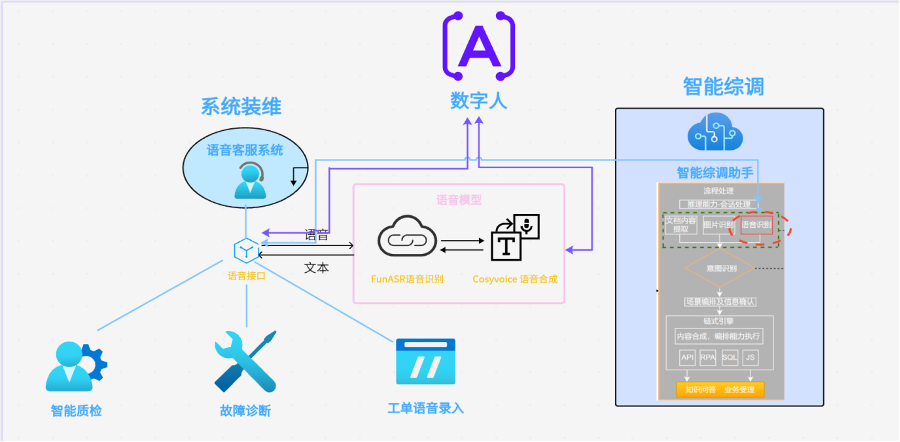

在运营商家宽业务支撑场景中,存在多个APP和系统需要与装维人员交互,传统的功能按钮点击型操作交互界面,越来越难以满足装维人员工作提效的迫切需求。家宽施工调度系统所需的AI语音能力主要包括ASR(音转字)和TTS(字转音)。主要有以下几点诉求:高效的语音转录、语音角色分离、生动的语音合成。

针对工业语音应用的单一化,AI语音模型还应该可以通过微调的方式定制属于自己的语言类别,比如各个地市的方言。

目前市面上开源的语言模型有很多,比较著名的有OpenAI提供的Whisper模型,Facebook AI 提出的wav2vec 2.0模型,FunAudioLLM的SenseVoice语音识别模型和CosyVoice语音合成模型,还有阿里达摩院开源的大型端到端语音识别框架FunASR。基于业务的技术能力需求,结合市面上的多个语言模型各自的特点,在保证语音识别质量的前提下,推理速度更快的FunASR更为适合。

FunASR语音识别框架提供多种功能,包括语音识别(ASR)、语音端点检测(VAD)、标点恢复、说话人分离和多人对话语音识别等。TTS模型选择有着出色音色复制功能的CosyVoice模型,实测发现在使用预训练模型推理时,CosyVoice有着良好的性能表现。

独特亮点:强大功能与易用性的完美结合

1.工业级模型: 基于超过60,000小时的中文数据和50,000小时的英文数据进行训练,确保提供卓越的识别精度。

2.实时与非实时解决方案:支持非实时的精准识别与实时应用场景的快速响应,满足多样化需求。

3.模块化架构设计:用户可以根据具体需求灵活选择和定制模块,如集成VAD、PUNC模型,从而提升应用的整体功能。

原理浅析:高效算法与灵活扩展性的无缝融合

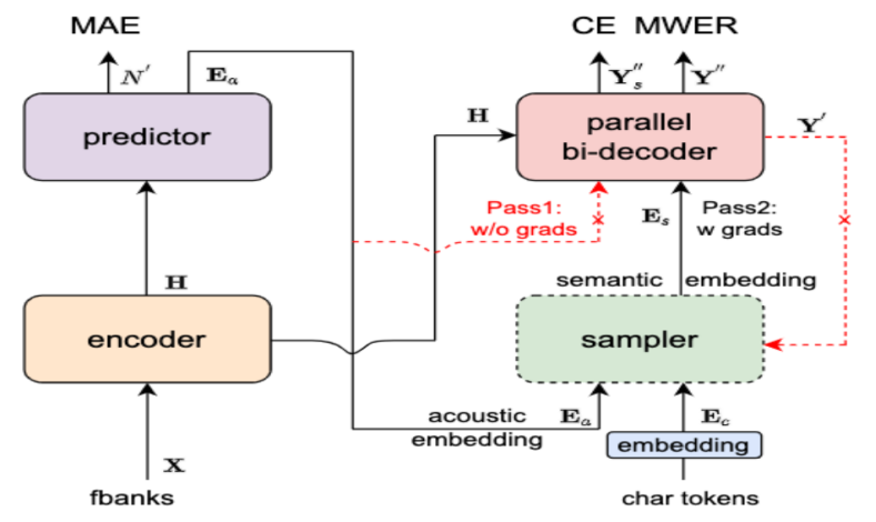

工具包的核心模型是Paraformer,这是一种高效的非自回归端到端语音识别模型,模型结构如下图所示。

来源于Modelscope Paraformer

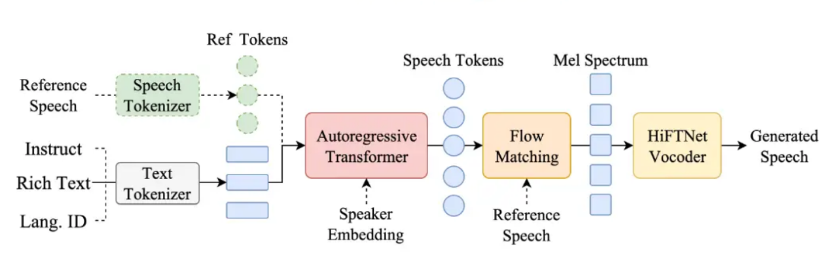

传统到革新:语音合成技术的演变

传统的TTS技术依赖于大量录音数据和复杂的特征工程,而CosyVoice另辟蹊径,它是基于大型语言模型(LLM)和监督语义令牌来生成语音,这些令牌与传统的无监督学习得到的令牌不同,它们能够更准确地捕捉到语义信息,并与文本对齐。模型结构图如下:

来源于Modelscope CosyVoice

核心亮点:开启零样本语音合成的全新时代

1.CosyVoice-300M:基座模型,仅仅需要3至10秒的原始音频就可以生成音色克隆,甚至涵盖韵律、情感等细微的方面,包括跨语种语音的生成。

2.CosyVoice-300M-SFT:微调版本,经过专门的数据集微调以提高特定任务或领域的语音生成质量。

3.CosyVoice-300M-Instruct:支持细粒度控制,包括对说话人身份、说话风格(情绪、性别、语速和音高)以及精细的副语言特征,这些特征包括插入笑声、呼吸、以及强调某些词语的能力。

语音识别(ASR)和语音合成(TTS)技术广泛应用在运营商装维方向,使得人机交互更加便捷,提升了工作效率,改善客户服务。

智能综调语音技术应用场景

1.语音客服系统: 通过ASR实时将用户的语音问题转化为文字,结合自然语言处理(NLP)技术进行问题分类,TTS则用于将系统的应答结果转化为语音反馈给用户。语音客服系统能够自动处理常见问题,减少人工客服的负担。

2.故障诊断: 装维人员可以通过语音描述故障现象,ASR自动转录为文字并录入系统;系统可以利用文本分析和历史故障数据进行初步诊断,给出故障排查建议。

3.工单语音录入:装维人员可以通过语音快速录入工单信息,ASR将其转化为结构化的文字内容,录入工单管理系统。可以包括设备状态、故障现象、修复措施等内容。

4.智能综调助手:用户除了输入文字给助手,可以直接语音录入,ASR模型将语音转为文字后转入下一个流程进行意图识别。

5.智能质检:人工客服处理改约审核时快速的从录音转文字中获取人员对话信息。

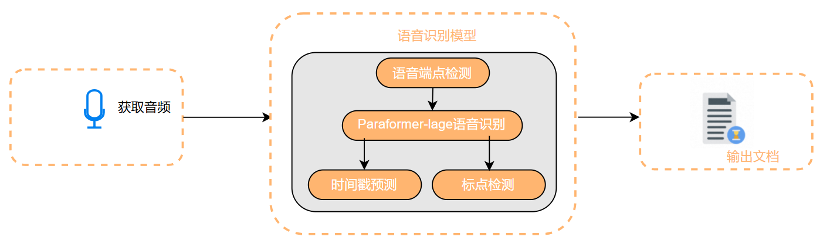

在实际使用中,为了提高Paraformer模型的预测性能,会在标准的Paraformer基础上增加了语音活动检测和时间戳预测模型。语音活动检测采用基于前馈时序记忆网络FSMN-VAD模型,它能够检测有效语音的起始和结束。为了提升ASR模型转录后文本的可读性,会对文本进行后处理,包括添加标点符号和去除语音不流畅性,采用的是FunASR提供的CT-Transformer模型,它能够在保证性能的同时利用快速解码策略来最小化延迟。

最终完整的FunASR语音识别模型处理流程如下图所示:

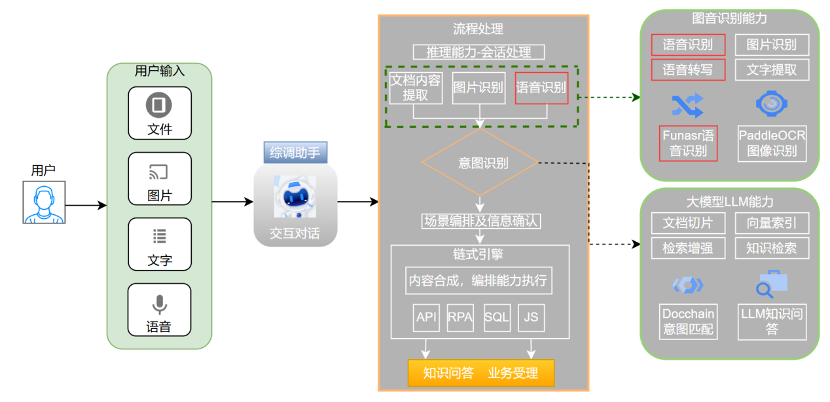

在业务受理流程中,采用大小模型结合,多模态受理的方法。比较典型的是在智能综调助手应用中,语音识别技术作为强有力的辅助工具,提高了产品的人机交互能力和业务的整体运作效率。语音模型将客户语音需求转为文字,然后经过大小模型进行意图判断,匹配到适合场景的意图后进入到链式引擎调用指定的API接口,从而完成AI大模型在业务受理的智能化全过程。

大模型结合语音技术业务全流程

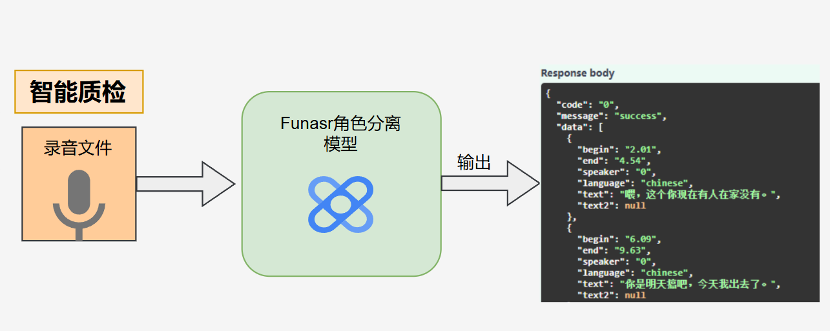

FunASR角色分离模型可用于智能质检板块。传统方式下人工客服在处理改约审核时,需要查看改约的图片以及录音,当录音较长时往往需要花费很多时间,FunASR角色分离模型不仅可以识别语音,还可以将多人对话区分,这样客服在审核时可以很快的了解到录音的内容,并准确定位到说话人。

使用FunASR对录音文件进行角色分离的示例过程

模型训练:个性化定制自己的语音模型

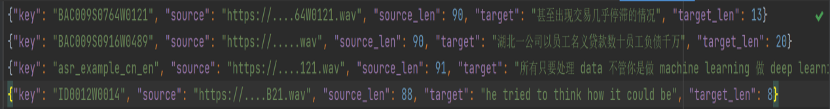

为了提升语音模型对地方方言的识别效果,需要对模型进行微调训练。FunASR官方提供简便的模型训练脚本,我们需要提前准备数据集并将数据集转换为特定的格式以满足模型输入。FunASR模型训练数据集的jsonl的格式如下图所示:

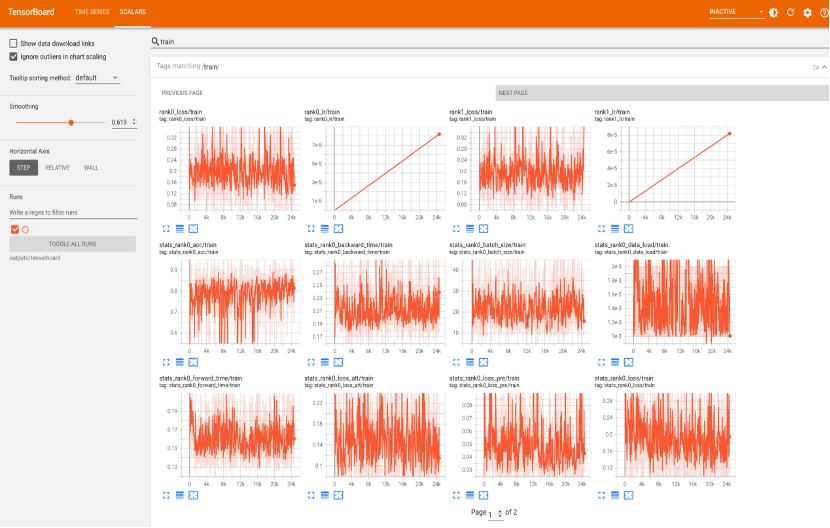

因为语音数据很多都长短不一,为了充分利用计算资源又防止出现OOM,每一批样本大小的选择根据实际情况指定单张GPU上可以处理的最大帧数即token值,训练批次根据数据集情况而定,其它的训练参数保持默认即可,可以通过tensorboard可视化查看训练过程,如图所示:

FunASR个性化语音训练过程

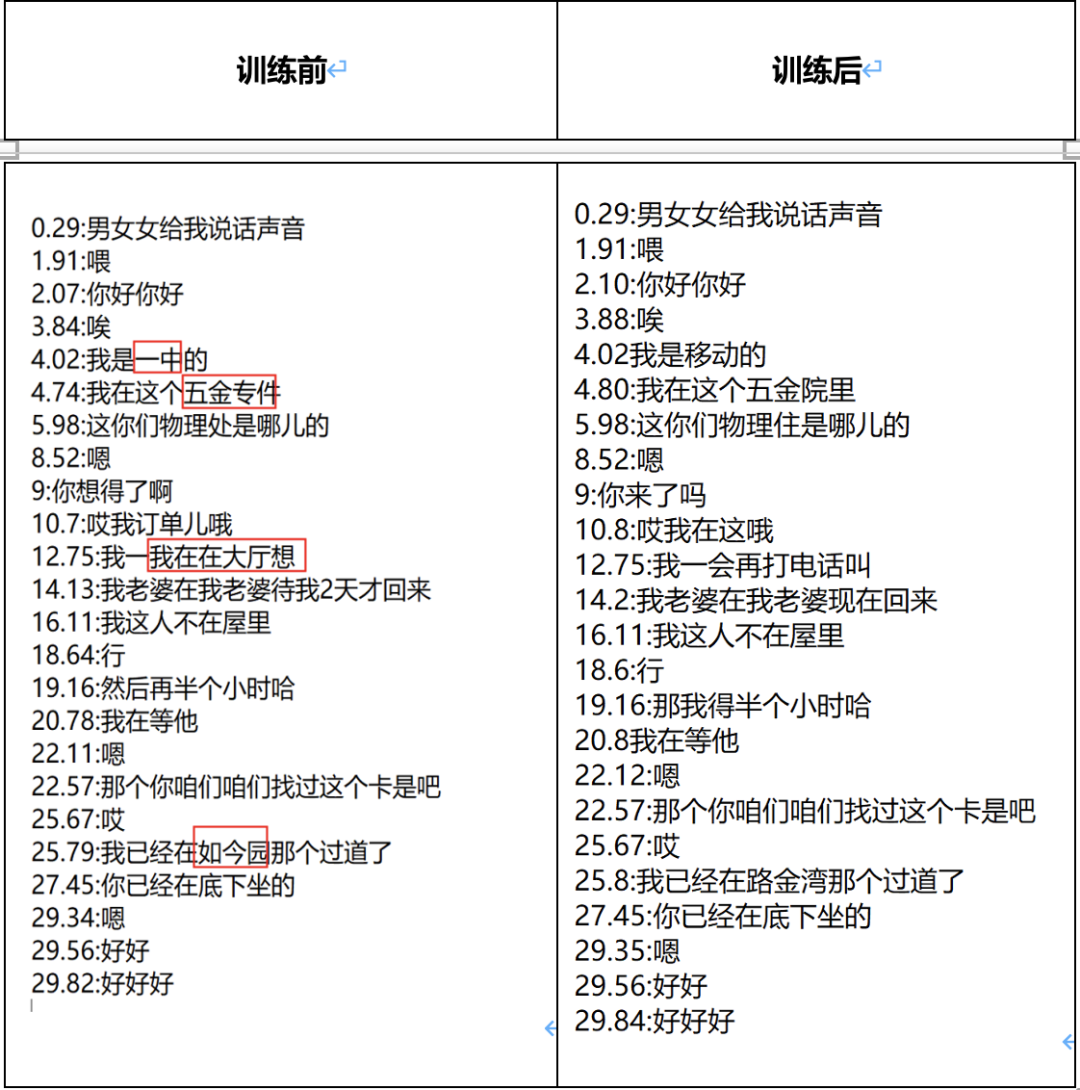

训练前后效果对比:

可以看出模型训练后对一些名词的识别准确了很多,比如微调前“移动”被识别为“一中”,“五金院里”识别为“五金专件”,“打电话”识别为“大厅”,“路金湾”识别为“如今园”等。

1.多语言多方言识别:在利用语音模型进行多方言训练时,音频数据大多来源于装维人员与客户的通话录音,文本标注都是线下人员手动录入,往往面临训练数据稀缺和数据采集错误的问题,这直接影响了模型的训练效果,导致模型在处理方言时准确性较低。后续对于数据集的收集,尝试通过在互联网上对一些公开的地方方言视频进行语音文字的抓取,然后通过后期整理,优化数据。

2.背景噪音与环境因素:在嘈杂的环境中,语音识别的准确率通常会下降,背景噪音、回声、多人同时说话等因素都会干扰模型的判断,导致错误识别,可以尝试采用一些传统的降噪技术比如利用python中的scipy 库,让语音通过低通滤波器进行简单的降噪,然后再进行语音识别处理。

3.实时处理与低延迟需求:在实际业务需求中,为了不影响用户体验,需要语音模型有较高的推理速度,这对模型的计算效率和资源优化提出了较高的要求。除了硬件方面的提升,还可以在模型初步加载语音时,采用异步的方式对语音文件进行切片,然后再送入模型推理,使其在多并发情况下也能保持良好的推理速度。

4.情感与语义理解:仅仅识别语音中的文字内容并不足够,很多场景还需要语音模型能够理解说话者的情感和语义。例如,客服场景中,系统需要感知用户是否处于焦虑、愤怒等情绪,以作出合适的回应。

未来,随着数据规模的增长与计算资源的增强,AI语音模型有望继续突破瓶颈,带来更加自然和高效的语音交互体验。期待在这一领域中,更多创新的出现,助力各行各业迈向智能化的新时代。